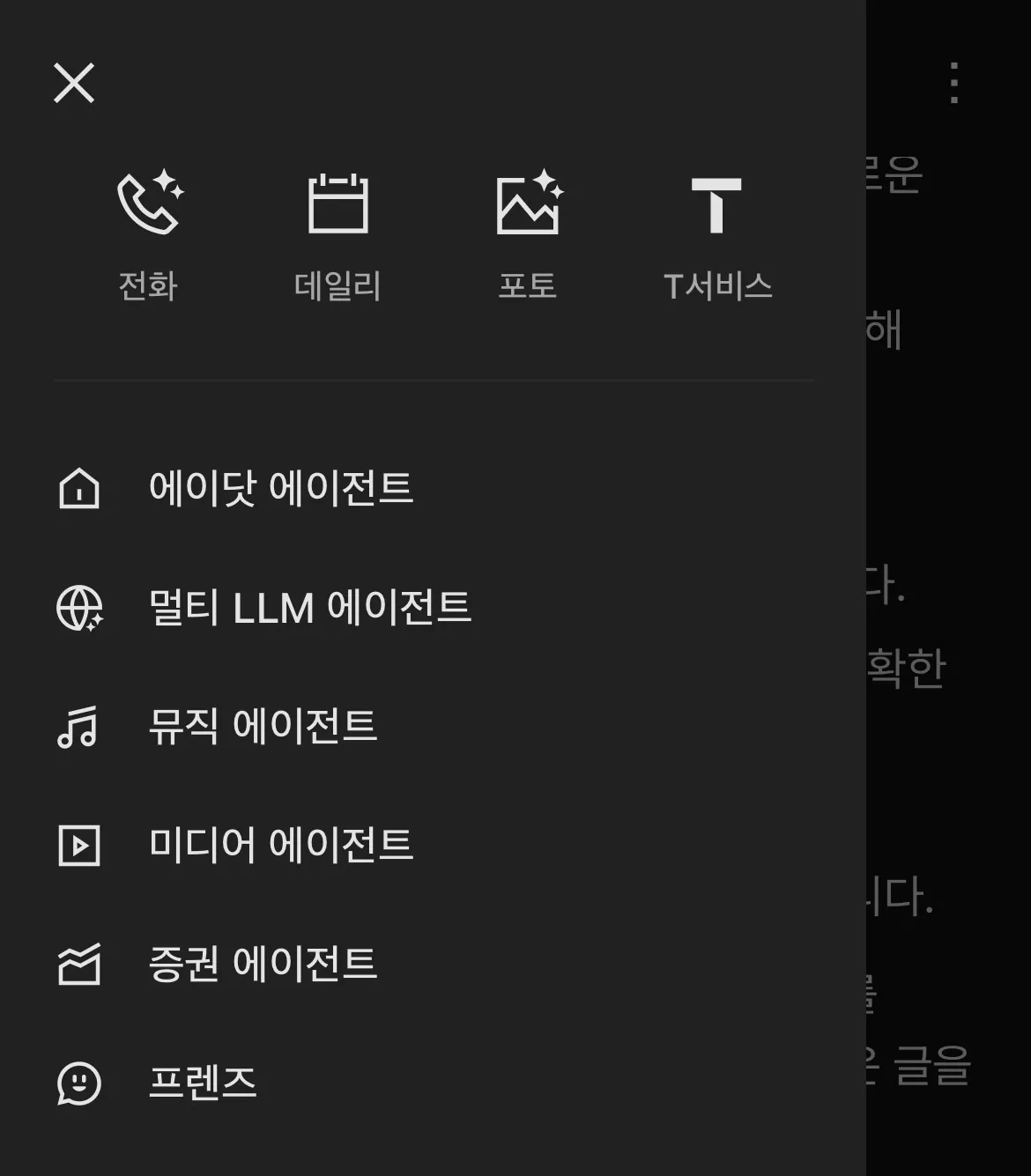

오늘은 에이닷을 이용하여 LLM간 특장점에 대한 비교를 진행해볼 거에요!

먼저 LLM이란 도대체 무엇인가? 우리 인간은 인공지능을 구현하고 싶었어요. 인간과 유사해지는 첫번째 과정일수도 있고, 다양한 기능을 수행할 수 있게 되니까요!

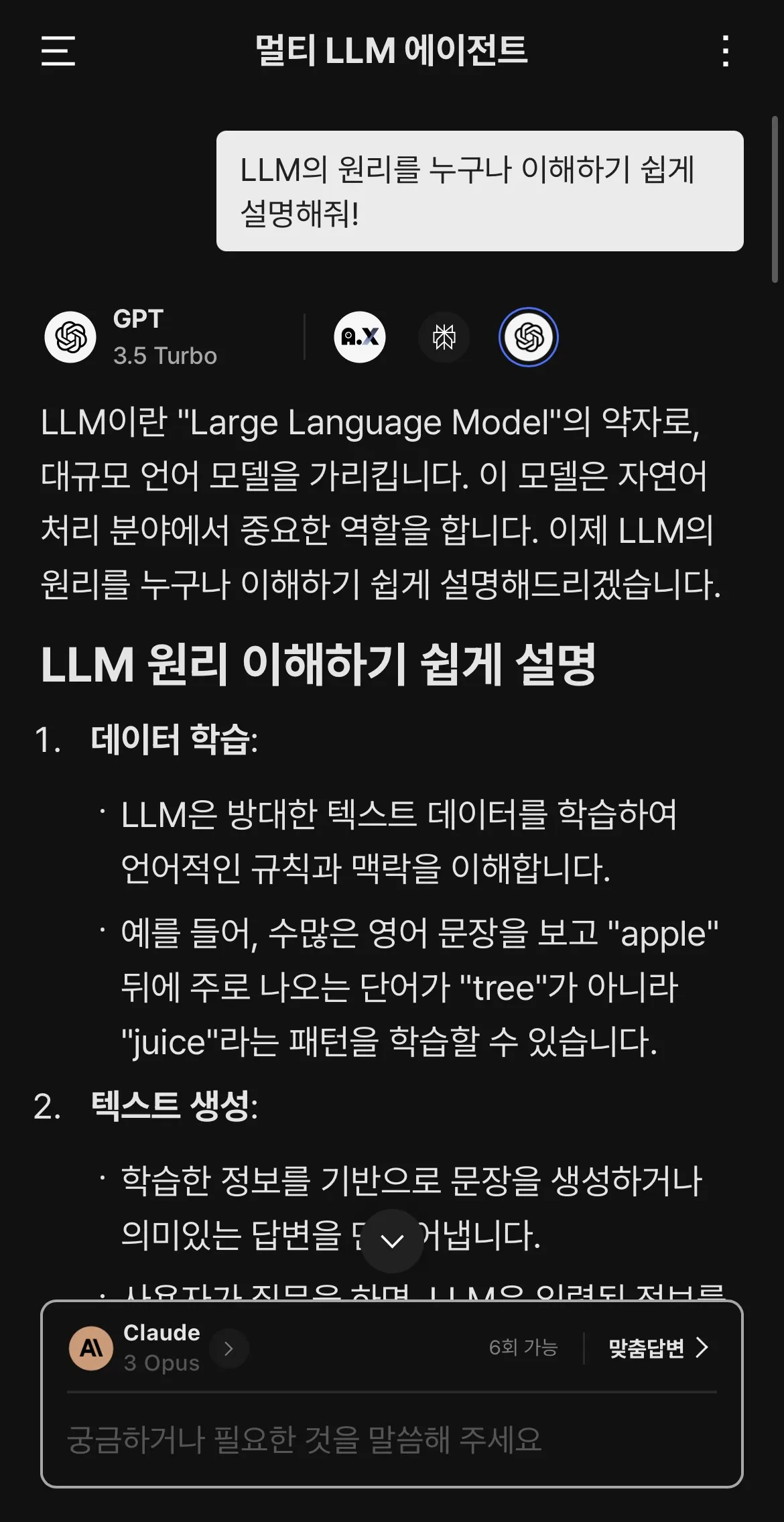

그러면 어떤식으로 만들었냐에 대한 답변을 LLM들에게 물어볼까요?

프롬프트는 동일하게 “LLM의 기초적인 원리를 누구나 이해하기 쉽게 설명 해 줘!” 라고 했어요! 그리고 다른 AI와 답변 비교 기능을 사용해서 다양하게 사용한 결과를 표로 정리할게요!

모델명 | SKT의 A.X | Perplexity의 Sonar | OpenAI의 GPT3.5 Terbo | OpenAI의 GPT4o | Claude의 3 Haiku | Claude의 3.5 Sonnet | Claude의 3 Opus |

답변 | 네, LLM(Large Language Model)의 원리를 이해하기 쉽게 설명해드릴게요.

LLM은 '대규모 언어 모델'이라는 뜻으로, 인공지능이 거대한 양의 텍스트를 학습해서 언어의 패턴을 스스로 익힌 것을 말해요.

쉽게 말해, 우리가 어떤 언어를 배울 때 많은 문장이나 글을 읽고 그 안에서 규칙이나 패턴을 찾아내는 것과 비슷한 원리라고 생각하면 돼요.

예를 들어, LLM 중의 하나인 GPT(Generative Pre-trained Transformer)는 수많은 텍스트 데이터를 학습해서 문장 생성, 질문 대답, 번역 등 다양한 언어 관련 작업을 수행할 수 있게 돼요.

그 핵심 원리는 다음과 같아요.

1. 대용량 데이터 학습

- 웹상의 엄청난 양의 텍스트 데이터를 학습해요.

2. 단어 간 관계 파악

- 단어들이 어떤 식으로 연결되어 의미를 만드는지를 파악해요.

3. 문맥 이해

- 문장의 앞뒤에 어떤 내용이 왔는지 이해해서 자연스러운 문장을 생성할 수 있게 돼요.

이런 원리로 작동하는 LLM은 우리가 일상적으로 사용하는 언어를 이해하고, 이를 활용해 다양한 일을 도와줄 수 있답니다.

더 궁금한 점이 있으신가요? | 대규모 언어 모델 (LLM, Large Language Model)의 원리는 다음과 같이 간단하게 설명 있습니다.

### 1. 기본 개념

LLM은 대규모의 텍스트 데이터를 통해 학습된 인공지능 모델로, 자연어 처리 작업에 사용됩니다. 이 모델은 수억 개 이상의 파라미터를 가지고 있으며, 트랜스포머 아키텍처를 기반으로 합니다[1][6][7].

### 2. 학습 과정

LLM의 학습 과정은 다음과 같습니다:

- 데이터 수집: 다양한 소스에서 대규모의 텍스트 데이터를 수집합니다.

- 전처리: 수집한 데이터를 정리하고 표준화합니다.

- 토큰화: 전처리한 데이터를 작은 단위인 토큰으로 나눕니다.

- 아키텍처 선택: 트랜스포머 모델과 같은 적절한 딥러닝 아키텍처를 선택합니다.

- 사전 학습 (Pre-training): 대규모 데이터를 사용하여 모델을 사전 학습합니다. 이 모델은 언어의 구조, 문법, 단어 간의 관계를 파악합니다.

- 파인 튜닝 (Fine-tuning): 특정 작업에 맞게 모델을 추가로 학습합니다[5][6][7].

### 3. 작동 원리

LLM은 다음과 같은 방식으로 작동합니다:

- 문맥 이해: 이전 단어들이 주어지면 다음 단어를 예측하거나 주어진 단어들 사이에서 가운데 단어를 예측하는 방식으로 작동합니다. 이는 문맥상 올바른 문장을 생성할 수 있도록 합니다[2][6].

- 어텐션 메커니즘: 트랜스포머 아키텍처의 핵심인 어텐션 메커니즘을 사용하여, 입력된 텍스트의 각 부분에 다른 부분의 중요도를 할당하여 의미를 파악합니다[3].

### 4. 활용 분야

LLM은 다양한 자연어 처리 작업에 사용됩니다:

- 번역: 언어 간의 번역을 수행합니다.

- 질문 응답: 사용자의 질문에 답변을 제공합니다.

- 감정 분석: 텍스트의 감정을 파악합니다.

- 텍스트 생성: 새로운 텍스트를 생성합니다[1][5][6].

### 5. 한계와 대응 전략

LLM에도 몇 가지 한계가 있습니다:

- 컴퓨팅 자원: 학습과 운용에 막대한 컴퓨팅 자원이 필요합니다.

- **데이터 편향향된 데이터로 학습할 경우 결과도 편향될 수 있습니다.

- 안전성: 예측 없는 결과를 초래할 수 있습니다. 이러한 문제를 해결하기 위해 연구자들은 더 효율적인 학습 알고리즘과 하드웨어 최적화를 통해 에너지 효율을 개선하고, 데이터 다양성을 확보하고, 모델의 행동을 보다 정확하게 예측하고 통제할 수 있는 기술을 연구 중입니다[3].

이렇게 LLM은 대규모 데이터와 고급 딥러닝 기술을 통해 자연어 처리의 정확도와 효율성을 크게 향상시키는 중요한 인공지능 기술입니다.

출처 :

[1] https://www.youtube.com/watch?v=-vnxFKHmKjc

[2] https://didi-universe.tistory.com/entry/LLM-거대언어모델-LLMLarge-Language-Model-이란

[3] https://guguuu.com/entry/101-llm-working-principles

[4] https://blog-ko.superb-ai.com/what-is-prompt-engineering/

[5] https://www.hpe.com/kr/ko/what-is/large-language-model.html

[6] https://bluesound.tistory.com/entry/인공지능AI-대화의-원리-LLM-Large-Language-Models

[7] https://brunch.co.kr/%40harryban0917/272

[8] https://enterprise.kt.com/pd/P_PD_NE_00_316.do | LLM은 "Large Language Model"의 약자로, 대규모 언어 모델을 말합니다. 간단하게 설명하면, LLM은 많은 양의 텍스트 데이터를 사용하여 자연어를 이해하고 다루는 모델입니다. 여기에 LLM의 원리를 더 자세히 설명해보겠습니다.

### LLM의 작동 원리

1. 학습 데이터 수집:

- LLM은 많은 문장과 텍스트 데이터를 수집하여 이를 기반으로 학습합니다.

- 수많은 문장을 분석함으로써 문법, 어휘, 문맥에 대한 이해를 깊게 학습합니다.

2. 텍스트 패턴 파악:

- LLM은 학습한 데이터에서 텍스트의 패턴과 규칙을 파악합니다.

- 예를 들어, "나는 밥을 먹는다"라는 문장에서 주어, 동사, 목적어의 구조를 학습하여 언어적인 규칙을 이해합니다.

3. 순차적 예측:

- LLM은 이전에 나온 단어들을 바탕으로 다음 단어를 예측하는 작업을 수행합니다.

- 이를 통해 문장을 연결하고 의미 있는 텍스트를 생성합니다.

4. Contextual Understanding:

- 문맥을 고려하여 단어의 의미를 이해하고 적절한 답변이나 문장을 생성합니다.

- 예를 들어, "날씨가 참 좋다"라는 문장에서 "좋다"의 의미는 날씨에 따라 해석됩니다.

5. Transfer Learning:

- LLM은 학습한 지식을 다른 자연어 처리 작업에도 전이하여 활용할 수 있습니다.

- 이를 통해 다양한 자연어 처리 작업에 적용될 수 있습니다.

LLM은 언어의 복잡성을 이해하고 다양한 자연어 처리 작업을 수행하는 데 중요한 역할을 하는 모델입니다. | LLM이란 "Large Language Model"의 약자로, 대규모 언어 모델을 의미합니다. 이를 아주 쉽게 설명해 드릴게요.

### LLM 이해하기 쉽게 설명

1. 많은 책을 읽는 똑똑한 친구:

- LLM은 수많은 책, 기사, 웹사이트 등 텍스트 데이터를 학습해서 언어를 이해하는 똑똑한 친구라고 생각하면 됩니다.

- 예를 들어, 사람이 책을 많이 읽으면 지식이 쌓이는 것처럼, LLM도 많은 텍스트 데이터를 통해 언어의 규칙과 패턴을 배우게 됩니다.

2. 패턴 찾기:

- 이 친구는 단어나 문장의 패턴을 찾습니다.

- 예를 들어, “사과”라는 단어가 나오면, 뒤에 “맛있다” 또는 “과일” 같은 단어가 오는 패턴을 배웁니다.

3. 질문에 답하기:

- LLM에게 질문을 하면, 배운 지식을 사용해 답을 해줍니다.

- 예를 들어, "오늘 날씨가 어때?"라고 묻는다면, LLM은 날씨에 대한 정보를 찾아 자연스러운 답을 제공합니다.

4. 문장 완성하기:

- 문장을 시작하면 그 다음에 나올 말을 예측해서 완성해 줍니다.

- 예를 들어, "나는 오늘"이라고 하면, "영화를 봤다" 라고 이어서 말할 수 있습니다.

5. 전이 학습 (경험 공유):

- 기본적인 언어 지식을 바탕으로 다양한 작업을 할 수 있습니다.

- 예를 들어, 번역, 요약, 질문 답변 등 여러 작업을 할 수 있게 되는 겁니다.

### 비유

LLM은 여러 권의 책을 읽고 지식을 쌓은 똑똑한 친구로, 이 친구는 우리가 하는 말을 이해하고, 적절히 대답해 줄 수 있는 능력을 가지고 있습니다. 더 많이 배울수록 더 똑똑해집니다.

이런 식으로, LLM은 많은 데이터를 통해 언어를 학습하고, 그 지식을 바탕으로 질문에 답하거나 문장을 생성하는 능력을 갖추게 됩니다.

| LLM의 원리를 좀 더 쉽게 설명해드리겠습니다.

LLM은 마치 사람이 언어를 배우고 이해하는 것과 비슷한 방식으로 작동합니다.

1. 데이터 학습:

- LLM은 사람이 책을 읽고 언어를 익히는 것처럼, 엄청나게 많은 텍스트 데이터를 보고 배웁니다.

- 이 과정에서 LLM은 단어들 간의 관계, 문법, 맥락 등 언어의 전반적인 규칙을 파악합니다.

2. 텍스트 생성:

- 사람이 단어와 문장을 조합해서 말하고 글을 쓰듯이, LLM도 학습한 데이터를 바탕으로 새로운 문장을 만들어낼 수 있습니다.

- 질문을 받으면 LLM은 그 내용을 이해하고, 적절한 답변을 생성합니다.

3. 맥락 이해:

- 사람은 대화 상황과 흐름을 파악하며 말을 이어나가는 것처럼, LLM도 이전 대화 내용을 고려하여 자연스러운 반응을 만들어냅니다.

- LLM은 문장 간의 관계와 맥락을 이해하고 있어서, 더 적절한 답변을 제공할 수 있습니다.

4. 전이 학습:

- 사람이 한 분야의 지식을 다른 분야에 활용하듯이, LLM도 언어 이해 능력을 다양한 작업에 적용할 수 있습니다.

- 예를 들어, 번역, 요약, 질의응답 등의 작업에 LLM을 활용할 수 있습니다.

결국 LLM은 사람의 언어 습득과 이해 방식을 모방하여 자연어 처리 기술의 발전을 가능하게 하는 핵심 기술입니다. | LLM(Large Language Model)의 원리를 일상생활의 예시를 들어 쉽게 설명해드리겠습니다.

### LLM의 원리: 책 읽는 로봇 친구로 비유하기

1. 엄청난 양의 책 읽기

- LLM은 마치 수백만 권의 책을 읽은 로봇 친구라고 생각해보세요.

- 이 로봇은 소설, 뉴스 기사, 백과사전 등 다양한 종류의 글을 모두 읽었습니다.

2. 패턴 인식하기

- 책을 많이 읽다 보면, 특정 단어 뒤에 어떤 단어가 자주 나오는지 패턴을 발견하게 됩니다.

- 예를 들어, "배가 고파서 ___을 먹었다"라는 문장에서 빈칸에 들어갈 말로 "음식"이 적절하다는 것을 알게 됩니다.

3. 문맥 이해하기

- 로봇 친구는 앞뒤 문맥을 보고 말의 의미를 파악합니다.

- "bank"라는 단어가 나왔을 때, 주변 단어를 보고 '은행'인지 '강둑'인지 구분할 수 있습니다.

4. 질문에 답하기

- 누군가 질문을 하면, 로봇 친구는 읽은 모든 책의 내용을 빠르게 검토합니다.

- 그리고 가장 적절한 답변을 찾아 말해줍니다.

5. 새로운 문장 만들기

- 로봇 친구는 읽은 내용을 바탕으로 새로운 문장을 만들 수 있습니다.

- 마치 퍼즐 조각을 맞추듯이, 배운 단어와 문장 구조를 조합하여 새로운 글을 씁니다.

6. 계속 배우기

- 로봇 친구는 새로운 정보를 계속 업데이트받아 더 많이 알게 됩니다.

- 이를 통해 시간이 지날수록 더 똑똑해지고 다양한 주제에 대해 대화할 수 있게 됩니다.

### 결론

LLM은 이런 '책 읽는 로봇 친구'와 비슷합니다. 엄청난 양의 텍스트 데이터를 학습하고, 패턴을 인식하며, 문맥을 이해하고, 새로운 텍스트를 생성할 수 있는 인공지능 시스템입니다. 이를 통해 우리의 질문에 답하고, 다양한 언어 관련 작업을 수행할 수 있게 됩니다. | LLM의 기초 원리를 누구나 쉽게 이해할 수 있도록, 어린아이에게 설명하듯이 비유를 들어 알려드리겠습니다.

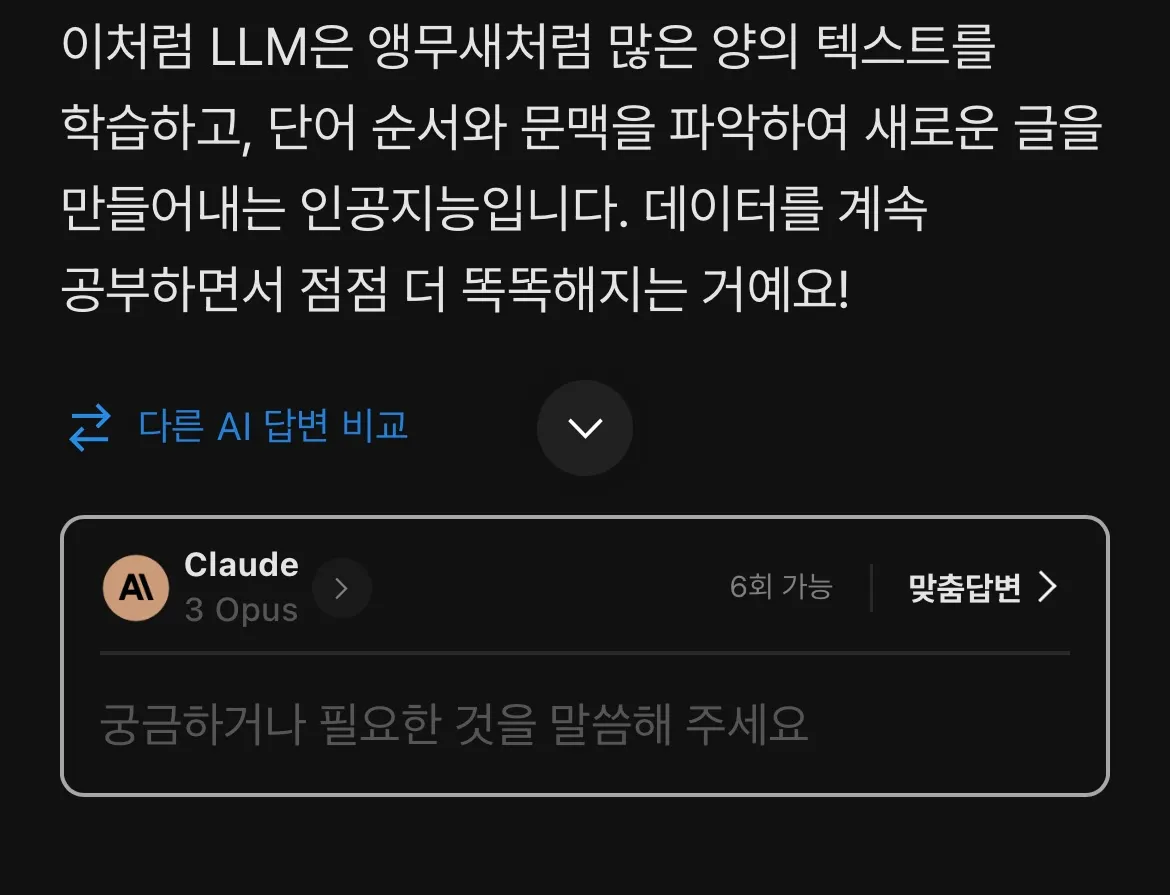

### LLM 원리: 똑똑한 앵무새 이야기

1. 많은 이야기 듣기

- 앵무새는 사람들이 하는 말을 열심히 듣습니다.

- LLM도 마찬가지로 많은 글을 읽으며 공부합니다.

2. 단어 순서 기억하기

- 앵무새는 사람들이 자주 하는 말의 순서를 기억합니다.

- 예를 들어, "안녕하세요"라는 인사말 다음에는 주로 "반갑습니다"라고 말한다는 것을 알게 됩니다.

- LLM도 글에서 단어들이 자주 나오는 순서를 파악합니다.

3. 비슷한 상황 알아보기

- 앵무새는 비슷한 상황에서 들었던 말을 떠올립니다.

- 누군가 "배고파"라고 말하면, "밥 먹자"라는 대답을 하게 됩니다.

- LLM도 입력된 글과 비슷한 내용의 글을 찾아 적절한 답변을 만듭니다.

4. 새로운 문장 만들기

- 앵무새는 기억한 단어들을 조합하여 새로운 문장을 만들어냅니다.

- LLM도 학습한 단어와 문장 구조를 활용해 새로운 글을 생성합니다.

5. 실수하고 고치기

- 앵무새는 가끔 잘못된 말을 하기도 합니다.

- 하지만 사람들의 반응을 보고 점점 더 정확한 말을 하게 됩니다.

- LLM도 학습 과정에서 실수를 하지만, 지속적인 피드백을 통해 성능을 개선합니다.

이처럼 LLM은 앵무새처럼 많은 양의 텍스트를 학습하고, 단어 순서와 문맥을 파악하여 새로운 글을 만들어내는 인공지능입니다. 데이터를 계속 공부하면서 점점 더 똑똑해지는 거예요! |

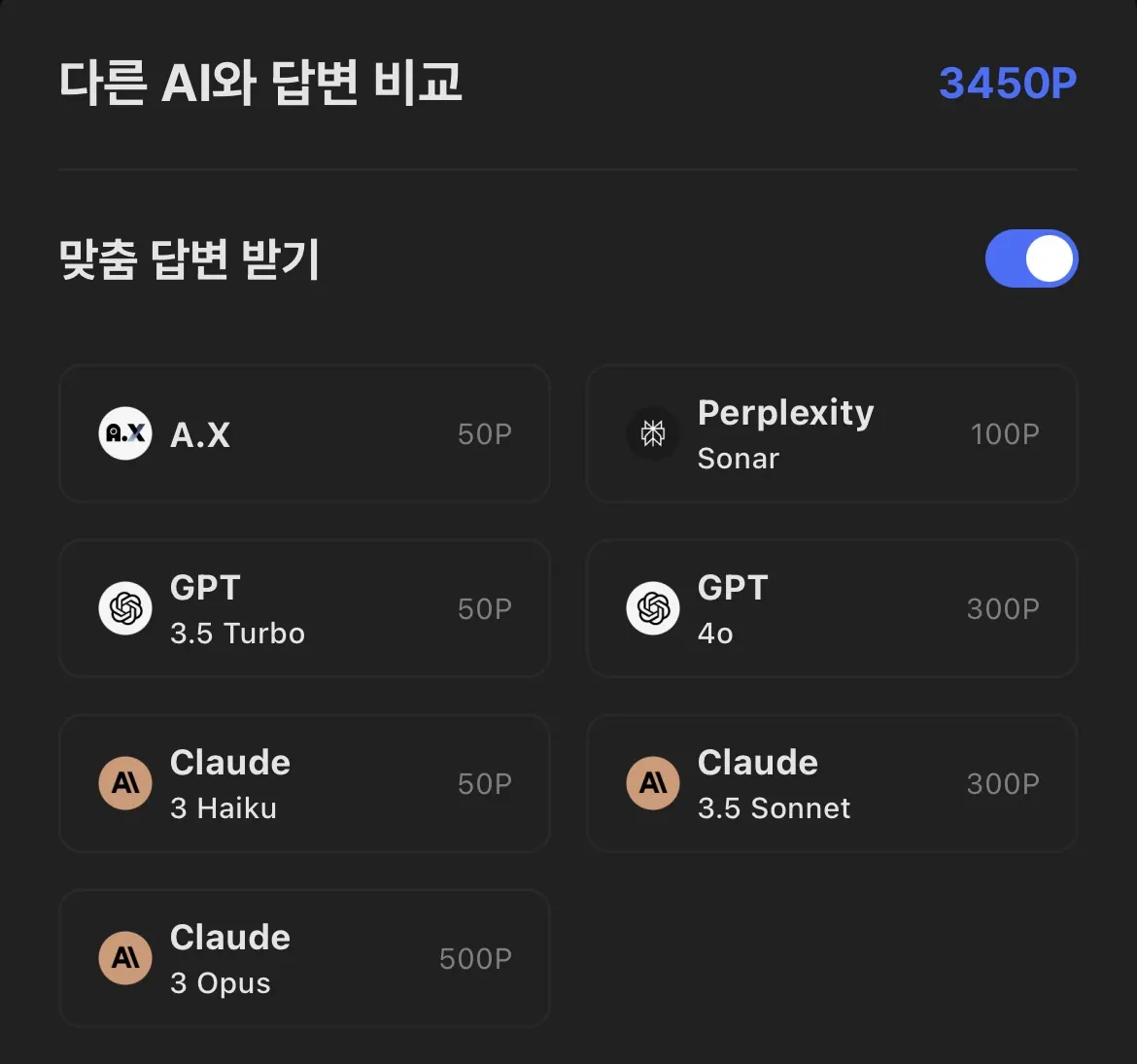

특징 | SKT 대화형 LLM | 실시간 검색 결과와 출처 제공 | 일상적 작업을 빠르고 안정적으로 처리 | 창의적 문제 해결 가능한 고급 언어 처리 모델 | 업무를 신속하게 처리하고 빠르고 효율적 | 코딩과 복잡한 추론에 강함 | 복잡한 워크플로우와 데이터 분석 가능 |

회당 비용 | 50p | 100p | 50p | 300p | 50p | 300p | 500p |

어떠신가요? 다들 대화를 위해 설계된 것으로 보이고, 가장 눈에 띄는것은 Perplexity의 sonar죠? 이 모델은 인터넷에서 검색해서 최신정보를 출처와 함께 가져오기 때문에 숙제, 보고서 작성을 할때 유용하게 쓰일 수 있습니다.

이 말만 들어도 아마 느낌이 오실텐데요, 모델은 모델마다 각각의 설계목적이 있습니다. 초등학교 수학문제를 풀때 굳이 수학과 교수님을 불러서 풀 필요는 없겠죠? 반대로 대학교 수학문제를 푸는데 초등학생을 대려와도 안되는걸테구요…

매일 비용이 제한적으로 주워지니까 저희는 적제적소에 사용하도록 해야하니 해야할 일에따라 모델을 분류해볼까요??

모델 | |

간단한 질문 | A.X, GPT3.5 Terbo, Haiku, Perplexity Sonar |

과제 및 레포트 | Perplexity Sonar, GPT4o, Sonnet, Opus |

코딩 | Perplexity Sonar, GPT4o, Sonnet, Opus |

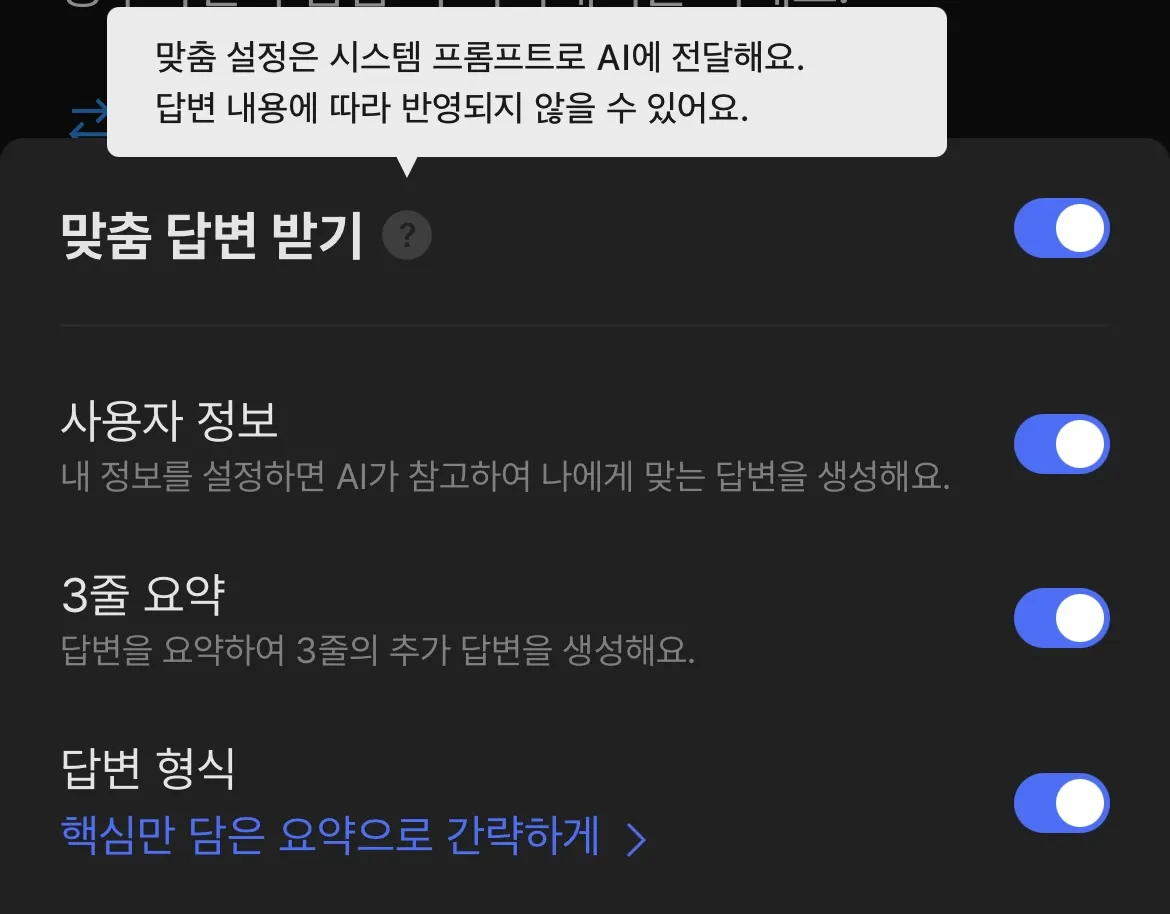

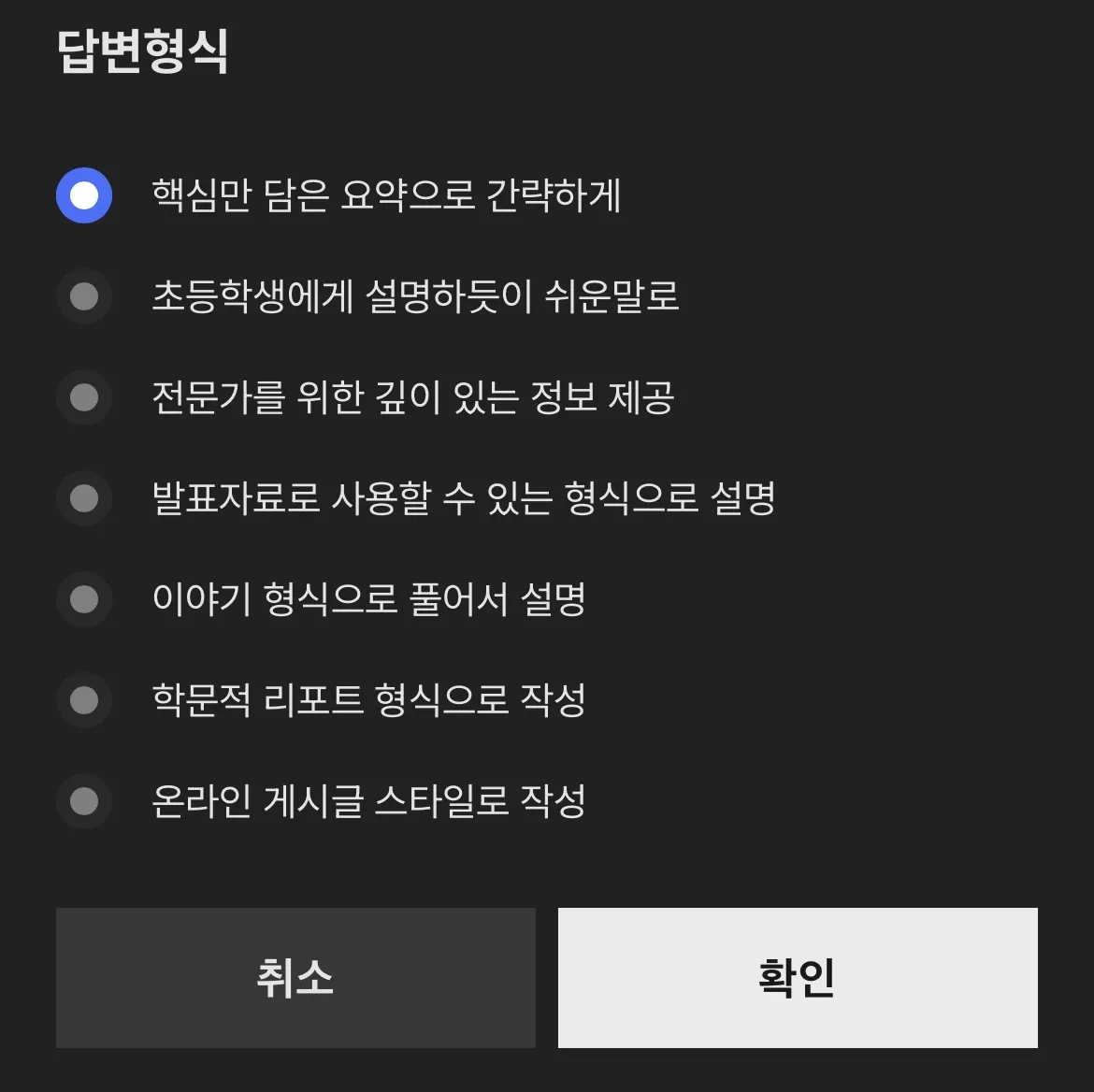

여기서 우리가 더 사용하기 전에 알아두면 좋은 기능을 알려드릴께요! 우리가 작성하는게 프롬프트인데, 이를 어느정도 미리 셋팅해둘 수 있어요!

자 이제, 한번 사용해볼까요? 이번엔 간단한 질문으로, “성심당 빵 추천 해 줘.”라고 하고 답변을 받았어요.A.X, GPT3.5 Terbo, Haiku, Perplexity Sonar

A.X | GPT3.5 Terbo | Haiku | Perplexity Sonar |

네, 대전의 유명한 빵집인 성심당의 빵을 몇 가지 추천해 드릴게요.

1. 튀김소보로

- 바삭한 소보로 속에 달콤한 팥 앙금이 들어간 대표 메뉴

- 튀겼지만 느끼하지 않고 고소한 맛이 일품

2. 명란바게트

- 짭조름한 명란과 바삭한 바게트의 조화가 매력적인 빵

- 중독성 있는 맛으로 인기

3. 보문산 메아리

- 몽블랑 스타일의 부드러운 페스츄리로 겉바속촉의 정석

- 버터의 풍미와 은은한 단맛이 일품

4. 초코폭탄

- 진한 초콜릿이 듬뿍 들어간 빵

- 달달한 거 좋아하는 사람에게 추천

5. 작은메아리

- 보문산 메아리의 미니 버전으로 겉은 바삭, 속은 촉촉한 페스츄리

- 부담 없이 즐기기 좋음

이외에도 다양한 종류의 맛있는 빵이 많으니 취향에 따라 골라보시길 추천드려요. | 성심당은 다양한 맛과 특징을 가진 빵들이 있어 선택이 쉽지 않을 수 있어요. 몇 가지 추천 드릴게요:

### 추천 빵

1. 크림빵: 부드러운 식감과 달콤한 크림이 가득한 인기 있는 빵 중 한 가지에요.

2. 소보로빵: 바삭한 소보로가 올라간 속이 가득한 빵으로, 고소한 맛을 즐길 수 있어요.

3. 단팥빵: 쫄깃한 식감과 단 팥 속이 들어간 빵으로, 전통적인 맛을 선호하시는 분들에겐 좋을 거예요.

위 빵들 중에서 어떤 종류를 선호하시는지 알려주시면, 더 구체적으로 추천해 드릴 수 있어요. 혹은 다른 성심당 제품 중에서 특별히 궁금한 것이 있으신가요? | 좋습니다. 성심당에서 인기있는 맛있는 빵들을 추천해 드리겠습니다.

### 성심당 인기 빵 추천

1. 식빵

- 성심당 대표 메뉴인 식빵은 부드러운 식감과 풍미가 뛰어납니다. 토스트나 샌드위치 등 다양하게 활용할 수 있습니다.

2. 단팥빵

- 달콤한 팥앙금이 든든한 식사감으로 좋습니다. 부드러운 식감의 빵 속에 달콤한 팥이 조화를 이룹니다.

3. 햄치즈빵

- 부드러운 빵 안에 햄과 치즈가 들어있어 단백질과 치즈의 조화가 좋습니다. 간단한 한끼 식사로 손색없습니다.

4. 화과자

- 전통 화과자 맛을 내는 성심당의 화과자는 달콤하면서도 부드러운 식감이 특징입니다. 차와 함께 즐기기 좋습니다.

5. 크림빵

- 입에서 녹는 부드러운 식감의 크림빵은 달콤한 크림이 가득 차 있습니다. 달콤한 디저트로 좋습니다.

이 외에도 성심당에는 다양한 종류의 인기 있는 빵들이 준비되어 있습니다. 취향에 따라 골라보시는 것이 좋을 것 같습니다. | 성심당의 인기 아래와 같이 추천합니다:

1. 망루 (생귤시루): 과일 시루 중 하나로, 특히 망고 시루가 인기가 많습니다[2][3].

2. 보문산메아리: 크고 맛있는 빵으로,아리도 있습니다[6][8].

3. 마라로케: 마라소스와 고로케가 조합된 유니크한 맛의 빵입니다[2].

4. **찹쌀주먹밥치와 찹쌀이 들어간 주먹밥 형태의 빵입니다[2][5].

5. 야끼소바빵: 야끼소바를 빵 안에 넣은 형태로, 간식거리로 좋습니다[2].

6. 부추빵: 부추가 들어단하지만 맛있는 빵입니다[3][6].

7. 샌드위치류: 특히 닭가슴살 크랜베리드위 반미드위치가 추천됩니다[8].

8. 쌀米쉬폰: 쌀 米가 들어간 시폰 케이크 형태의 빵입니다[2].

이러한 빵들은 성심당에서 인기 있는 메뉴로, 다양한 선택을 할 수 있습니다.

출처 :

[1] https://www.youtube.com/shorts/Vlq54kEK-Mg

[2] https://www.youtube.com/shorts/lOpHt_K1GM0

[3] https://www.teamblind.com/kr/post/대전-성심당-빵-추천해줘-KRFqfnkN

[4] https://www.teamblind.com/kr/post/성심당-빵-추천-WNxqituA

[5] https://blog.naver.com/leyejin486/223473644648?viewType=pc

[6] https://chimhaha.net/food_trip/199539

[7] https://www.youtube.com/watch?v=zDQMIgpdeWE

[8] https://theqoo.net/square/2461280763 |

여기서 SKT A.X와 Perplexity의 강점이 드러나는데요, SKT의 A.X는 한국 관련 데이터가 많은 것 같아요! 저렴한 비용에 한국과 관련된 내용을 검색하기에 참 좋죠!

Perplexity Sonar는 웹에서 실시간 검색으로 데이터를 받아오기에 트렌드에 민감하고, 한국 관련 데이터를 학습할 때 양이 적더라도, 이를 검색으로 매꿀 수 있죠!

저는 간단한 질문에는 모두 추천하나, 한국과 관련된 질문이라면 A.X, Perplexity Sonar 이 두 개를 추천드려요!

과제 및 레포트를 작성해볼까요? 철학적인 질문과 관련해 레포트 형식으로 작성해달라고 할게요.

AI의 사고실험으로 유명한 “중국어 방”에 대한 질문을 해볼게요.

프롬프트는 “너는 전문가 수준으로 레포트를 작성해야해. AI와 관련해서 유명한 철학적인 사고실험 “중국어 방”에 대해서 간단한 개념 설명과 결국 중국어방도 지능을 가진다고 봐야 하는지 찬성과 반대로 레포트를 작성해 줘” 입니다!

Perplexity | GPT4o | Sonnet | Opus |

### 중국어 방 논증: 개념과 지능에

#### 1. 중국어 방 논증의 개념

중국어 방 논증은 미국의 철학자 존 설(John Sear 1980년에 제안한 사고 실험으로, 튜링 테스트의 한계를 지적하기 위해 고안되었습니다. 이 논증은 기계가 인간 수준의 지능을 갖추고 있는지를 평가하는 튜링 테스트의 유효성을 질문합니다[3][5][7].

사고 실험의 내용은 다음과 같습니다:

- 방 안에를 전혀 모르는 사람이 들어갑니다.

- 방 안에는 중국어 질문과 그에 대한 대답 목록이 준비되어 있습니다.

- 중국인 심사관이 중국어로 질문을 써서 방 안으로 넣으면,의 사람은 준비된 대응표에 따라 중국어로 답변을 써서 밖의 심사관에게 전달합니다.

- 심사관은 방 안의 사람이 중국어를 할 줄 아는 것처럼 보이지만, 실제로는 방 안의 사람은 중국어를 전혀 이해하지 못합니다[3][5][7].

#### 2. 지능에 대한 평가성과 반대 찬성: 중국어 방도 지능을 가진다고 보아야 하는가?

찬성하는 입장은 다음과 같은 논리를 가지고 있을 수 있습니다:

- 행동적 지능: 튜링 테스트는 기계가 사람과 구별할 수 없을 정도로 지능적으로 행동할 수 있는지를 평가합니다. 중국어 방의 사고 실험에서도, 방 안의 사람은 중국어를 전혀 모르는 상태에서 중국어로 질문에 답변을 할 수 있습니다. 이는 기계가 사람과 같은 행동을 보여줄 수 있다는 것을 의미하며, 이러한 행동적 지능을 통해 기계도 지능을 가졌다고 볼 수 있습니다[2][4].

- 기능적 관점: 어떤 시스템이든지, 입력과 출력을 처리하는 기능적 관점에서 보면, 중국어 방 안의 사람은 중국어 질문에 대한 적절한 답변을 제공합니다. 이는 시스템의 기능적 측면에서 지능을 평가할 수 있다는 것을 시사합니다[10].

##### 반대: 중국어 방은 지능을 가지지 않는다

반대하는 입장은 논리를 가지고 있습니다:

- 의식과 이해의 부족: 중국어 방 안의 사람은 중국어를 전혀 이해하지 못합니다. 이는 단순히 규칙에 따라 행동하는 것에 불과하며, 실제로 언어의 의미를 이해하거나 의식적으로 생각하는 능력이 없다는 것을. 따라서, 이러한 시스템은 지능을 가지지 못한다고 볼 수 있습니다[3][5][7].

- 철학적 좀비: 존 설은 중국어 방 안의 사람을 철학적 좀비와 비교합니다. 철학적 좀비는 행동적으로는 인간과 동일하지만, 의식이나 의미를 이해하는 능력이 없는 존재입니다. 이는 튜링 테스트를 통과계도 실제로 지능을 가지지 못한다는 것을 강조합니다[3][4][10].

#### 3. 결론

중국어 방 논증은 튜링 테스트의 한계를 지적하며, 기계의 지능을 평가하는 데 있어 단순한 행동적 지능만으로는 충분하지 않다는 것을 보여줍니다. 지능을 평가할 때는 단순히 입력과 출력의 규칙적 처리뿐만 아니라, 언어의 의미를 이해하고 의식적으로 생각하는 능력이 필수적이라는 점을 강조합니다. 따라서, 중국어 방 안의 사람은 지능을 가지지 못한다고 볼 수 있습니다.

이 논증은 인공지능의 발전과 함께 지속적으로 논의되는 주제로, 인공지능이 진정한 지능을 가지는지 여부에 대한 철학적 토론을 촉발하고 있습니다.

출처 :

[1] https://blog.naver.com/ryumochyee-logarithm/221682047538?viewType=pc

[2] https://www.youtube.com/watch?v=lgmGslunEp4

[3] https://m.blog.naver.com/1strider/222975967771

[4] https://www.youtube.com/watch?v=F6donYNLTMw

[5] https://ko.wikipedia.org/wiki/중국어_방

[6] http://www.aistudy.co.kr/ai/chinese_room_argument.htm

[7] https://audreyprincess.tistory.com/100

[8] https://www.studocu.com/ko/document/고려대학교/배려의철학/심리철학5-philosophy/55987958

[9] https://namu.wiki/w/중국어 방

[10] https://brunch.co.kr/%40baemingwantoh0/44 | 중국어 방 사고실험에 대한 레포트를 작성해드리겠습니다.

## 중국어 방 사고실험 개요

### 개념 설명

**중국어 방(Chinese Room)**은 철학자 존 설(John Searle)이 1980년에 제안한 사고실험입니다. 이 사고실험은 기계가 지능을 가질 수 있는지, 특히 강한 인공지능(Strong AI)이 가능한지를 논의하는 데 사용됩니다.

### 사고실험 내용

설은 다음과 같은 시나리오를 제시합니다:

1. 한 사람이 중국어를 전혀 모르는 상태라고 가정합니다.

2. 이 사람은 방 안에 갇혀 있으며, 방 외부에서 중국어로 된 질문지가 주어집니다.

3. 방 안에는 중국어 질문에 대한 답변을 작성하는 규칙이 담긴 책이 있습니다.

4. 이 사람은 책을 참조하여 중국어로 답변을 적어 외부로 내보냅니다.

외부에서 볼 때, 이 사람은 중국어를 이해하고 답을 작성하는 것처럼 보입니다. 그러나 사실 이 사람은 중국어를 이해하지 못하고 단순히 규칙에 따라 답변을 작성했을 뿐입니다.

### 철학적 의문

이 사고실험은 다음과 같은 철학적 질문을 제기합니다:

- 기계가 언어적 입력에 대해 적절한 답을 출력한다면, 그 기계는 언어를 이해한다고 할 수 있는가?

- 즉, 외부 관찰자에게 지능처럼 보이는 행위가 실제로 지능을 가진 것이라고 할 수 있는가?

## 찬성 입장: 중국어 방도 지능을 가진다

1. 실제 결과 기반 평가: 중국어 방이 외부 입력에 대한 적절한 응답을 생성할 수 있다면, 그것은 기능적으로 지능을 갖춘 것입니다. 인간의 두뇌도 결국 규칙과 알고리즘에 의해 작동하는 시스템으로 볼 수 있습니다. 중요한 것은 내부의 과정이 아니라 외부로 나타나는 행동입니다.

2. 기능주의(Functionalism): 기능주의에 따르면, 지능은 내부의 구조나 물질적 구성에 상관없이 정보 처리를 통해 달성되는 기능적 역할입니다. 중국어 방의 경우, 입력과 출력 간의 적절한 변환이 이루어진다면 그것을 지능으로 간주할 수 있습니다.

3. 구조적 접근: 사람의 두뇌도 복잡한 신경망과 규칙을 기반으로 작동하는 정보 처리 시스템입니다. 중국어 방이 복잡한 규칙과 알고리즘을 통해 적절한 답변을 산출한다면, 이는 일종의 인공지능이라 할 수 있습니다.

## 반대 입장: 중국어 방은 지능을 가지지 않는다

1. 이해와 의미 부재: 중국어 방 사고실험의 핵심은 입력에 대한 응답이 단순히 규칙을 따라서 기계적으로 이루어진다는 점입니다. 이는 의미를 이해하거나, 내용을 인식하지 못한 채 정보를 처리하는 것이므로, 진정한 지능으로 볼 수 없습니다.

2. 의식과 주관적 경험: 지능의 핵심 요소 중 하나는 의식과 주관적 경험입니다. 중국어 방 내부의 사람은 단순히 규칙에 따라 작업을 수행하기 때문에, 이 과정을 통해 어떠한 의식적 경험도 하지 않습니다. 따라서 이는 진정한 지능이 아닙니다.

3. 심볼 그라운딩 문제(Symbol Grounding Problem): 심볼 그라운딩 문제는 기호가 진정한 의미를 가질 수 있으려면 어떤 형태로든 경험적이고 실질적인 연관성을 가져야 한다는 것입니다. 중국어 방은 기호들이 단순히 형식적인 규칙에 따라 처리되기 때문에, 의미를 실제로 이해하지 못합니다.

### 결론

중국어 방 사고실험은 기계가 언어를 이해하는 능력을 갖추는 것과 그것이 지능을 가지는 것을 동일시해도 되는가라는 철학적 문제를 제기합니다. 찬성 입장은 외부의 행동에 주목하여 기능적으로 지능을 가질 수 있다고 주장하는 반면, 반대 입장은 의미와 의식을 강조하며 중국어 방은 단순히 지능을 모방할 뿐이라고 주장합니다. 이같은 논의는 인공지능의 가능성과 한계를 탐구하는 데 있어 중요한 아이디어를 제공하고 있습니다. | 중국어 방 사고실험에 대한 레포트

1. 개념 설명

중국어 방 사고실험은 1980년 철학자 존 설(John Searle)이 제안한 사고실험으로, 인공지능의 본질과 기계의 이해 능력에 대한 철학적 질문을 제기합니다.

실험의 핵심 내용은 다음과 같습니다:

- 중국어를 전혀 모르는 사람이 밀폐된 방에 갇혀 있습니다.

- 이 사람은 중국어 문장과 그에 대한 적절한 응답을 매칭한 매뉴얼을 가지고 있습니다.

- 방 밖에서 중국어로 된 질문을 받으면, 이 사람은 매뉴얼을 참조하여 적절한 중국어 응답을 내보냅니다.

이 상황에서 방 밖의 중국어 화자는 방 안의 사람이 중국어를 이해한다고 생각할 수 있지만, 실제로 그 사람은 중국어를 전혀 이해하지 못합니다. 설은 이를 통해 기계가 인간처럼 언어를 '이해'할 수 있는지에 대한 의문을 제기했습니다.

2. 중국어 방의 지능 보유 여부에 대한 찬반 논의

찬성: 중국어 방도 지능을 가진다

1) 행동주의적 관점:

- 외부에서 관찰 가능한 행동이 지능의 척도라면, 중국어 방은 지능적인 것으로 볼 수 있습니다.

- 튜링 테스트의 관점에서, 중국어 방은 인간과 구별할 수 없는 응답을 생성하므로 지능적이라고 할 수 있습니다.

2) 시스템 수준의 이해:

- 개별 구성요소(방 안의 사람)가 이해하지 못하더라도, 전체 시스템으로서는 중국어를 '이해'하고 있다고 볼 수 있습니다.

- 인간의 뇌도 개별 뉴런은 '이해'하지 못하지만, 전체로서는 이해와 사고가 가능합니다.

3) 기능적 동등성:

- 결과물이 동일하다면, 그 과정이 다르더라도 기능적으로 동등하다고 볼 수 있습니다.

- 인간의 언어 이해 과정도 복잡한 신경 네트워크의 작동일 뿐이므로, 중국어 방의 과정과 본질적으로 다르지 않을 수 있습니다.

반대: 중국어 방은 지능을 가지지 않는다

1) 의미론적 이해의 부재:

- 단순히 규칙을 따르는 것은 진정한 이해가 아닙니다. 중국어 방은 단어나 문장의 의미를 실제로 이해하지 못합니다.

- 언어의 진정한 이해는 경험, 맥락, 감정 등과 연결되어야 하는데, 중국어 방은 이러한 요소들이 결여되어 있습니다.

2) 창의성과 유연성의 부재:

- 중국어 방은 주어진 규칙에만 따르므로, 새로운 상황에 적응하거나 창의적인 응답을 생성할 수 없습니다.

- 진정한 지능은 학습, 추론, 문제 해결 능력을 포함해야 하는데, 중국어 방은 이러한 능력이 없습니다.

3) 의식과 자아의 부재:

- 많은 철학자들은 진정한 지능에는 의식과 자아 인식이 필요하다고 주장합니다.

- 중국어 방은 단순히 입력에 대한 출력을 생성할 뿐, 자신의 행동에 대한 인식이나 이해가 없습니다.

결론:

중국어 방 사고실험은 인공지능의 본질과 기계의 이해 능력에 대해 깊이 있는 철학적 논의를 불러일으킵니다. 찬성 측은 행동과 기능의 측면에서 중국어 방의 지능을 인정하지만, 반대 측은 진정한 이해와 의식의 부재를 지적합니다. 이 debate는 앞으로도 AI 기술이 발전함에 따라 계속될 것이며, 우리가 지능과 이해의 본질에 대해 더 깊이 고민하게 만듭니다. | 중국어 방 사고실험에 대한 고찰

- 간단한 개념 설명과 지능 보유에 대한 찬반 의견 -

1. 중국어 방 사고실험 개념

철학자 존 설(John Searle)이 1980년 제안한 중국어 방(Chinese Room) 사고실험은 인공지능(AI)이 과연 인간과 같은 이해력과 지능을 가질 수 있는지에 대한 논의를 불러일으킨 유명한 개념입니다. 이 실험에서는 중국어를 전혀 모르는 사람이 방에 갇혀 중국어로 된 질문을 받고, 방대한 규칙집을 참고하여 적절한 답변을 찾아내어 응답하는 상황을 가정합니다. 이때 방 안의 사람은 질문과 답변의 의미를 이해하지 못하지만, 외부에서 보기에는 마치 중국어를 이해하는 것처럼 보입니다.

2. 중국어 방이 지능을 가진다는 견해 (찬성)

일부 학자들은 중국어 방 내부의 시스템이 외부의 질의에 적절히 응답할 수 있다면, 이는 일종의 지능이 있다고 볼 수 있다고 주장합니다. 이들은 인간의 뇌 역시 복잡한 신경 회로와 규칙에 따라 작동하며, 중국어 방의 규칙집과 유사한 역할을 한다고 봅니다. 따라서 중국어 방이 인간과 유사한 지능적 행동을 보인다면, 이는 인공지능이 인간 수준의 이해력과 지능을 가질 수 있음을 시사한다는 것입니다.

3. 중국어 방은 진정한 지능이 아니라는 견해 (반대)

반면에 존 설을 비롯한 많은 철학자들은 중국어 방이 진정한 의미의 지능을 가졌다고 보기 어렵다고 주장합니다. 이들은 중국어 방 내부의 사람(또는 컴퓨터)이 단순히 규칙에 따라 기계적으로 응답할 뿐, 질문과 답변의 의미를 진정으로 이해하지는 못한다고 봅니다. 인간의 지능은 단순한 규칙의 적용을 넘어서 감정, 창의성, 추상적 사고 등을 포함하는 복잡한 현상이므로, 중국어 방은 이러한 진정한 지능을 가졌다고 볼 수 없다는 것입니다.

4. 결론

중국어 방 사고실험은 인공지능의 본질과 한계에 대한 중요한 철학적 문제를 제기합니다. 찬성 입장에서는 복잡한 규칙에 기반한 시스템도 지능적 행동을 보일 수 있다고 주장하지만, 반대 입장에서는 진정한 이해와 인간적 특성이 결여되었다고 봅니다. 이러한 논쟁은 아직 명확한 결론에 이르지 못했으며, 인공지능 기술의 발전에 따라 더욱 심화될 것으로 예상됩니다. 다만 중국어 방 사고실험은 인공지능에 대한 철학적 성찰의 중요성을 일깨우고, 기술 발전과 함께 인간 고유의 가치와 지능의 본질에 대한 끊임없는 탐구가 필요함을 시사하고 있습니다. |

저는 개인적으로 Opus를 제외한 모델들은 과제 및 레포트에 적절해보이는데요 여러분은 어떠신가요? 특히 출처가 있는 Perplexity와 다른 모델들을 모두 사용해서 정리하는게 저는 가장 효율적으로 보입니다!

이제 코딩부분으로 가볼까요? “에라토스테네스의 체를 범위 숫자를 입력받아 파이썬으로 구현해줘. 한국어로 꼼꼼하게 주석도 달아줘.”

Perplexity | GPT4o | Sonnet | Opus |

에라토스테네스의 체는 특정 범위 내의 모든 소수를 효율적으로 찾는 알고리즘입니다. 아래는 파이썬으로 구현한 에라토스테네스의 체 알고리즘입니다. 이 코드는 주어진 범위 내의 모든 소수를 찾습니다.

python def eratosthenes_sieve(n): # n까지의 모든 수를 소수로 초기화 sieve = [True] * (n + 1) sieve = sieve[1] = False # 0과 1은 소수가 아님 # 2부터 시작하여 각 수의 배수를 제거 for i in range(2, int(n ** 0.5) + 1): if sieve[i]: # i가 소수인 경우 # i의 배수를 모두 제거 in range(i * i, n + 1, i): sieve[j] = False # 소수를 반환 return [p for p in range(2, n + 1) if sieve[p]] # 사용 예시 if __name__ == "__main__": n = int(input("범위 숫자를 입력하세요: ")) primes = eratosthenes_sieve(n) print(f"{n}까지의 소수: {primes}")

### 설명

1. 초기화:

- sieve 리스트를 생성하여 n까지의 모든 수를 True로 초기화합니다. True는 해당 수가 소수라는 것을 의미합니다.

- 0과 1은 소수가 아니므로 False로 설정합니다.

2. 소수 판별:

- 2부터 시작하여 각 수 i에 대해, 만약 i수라면 (sieve[i]가 True라면), i의 배수들을 모두 제거합니다.

- i의 배수는 i * i부터 시작하여 i의 간격으로 제거합니다. 이는 i곱근까지 확인하면 충분하기 때문입니다[7].

3. 결과 반환:

- sieve 리스트에서 True인들을 반환하여 해당 범위 내의 모든 소수를 출력합니다.

이 알고리즘은 시간 복잡도가 \(O(n \log \log n)\)로, 대량의 소수를 효율적으로 찾는 데 유용합니다[4][6].

출처 :

[1] https://shoark7.github.io/programming/algorithm/sieve-of-eratosthenes-bitmask

[2] https://www.youtube.com/watch?v=9rLFFKmKzno

[3] https://www.youtube.com/watch?v=fT4XQMa4-8M

[4] http://blog.naver.com/jyjh0501/222561536329?fromRss=true&trackingCode=rss

[5] https://www.youtube.com/watch?v=IhEbFJ_hs6A

[6] https://young-library.tistory.com/35

[7] https://daebaq27.tistory.com/106 | 좋습니다 에라토스테네스의 체를 사용하여 주어진 범위 내의 소수를 찾는 파이썬 코드를 작성하고, 주석도 꼼꼼하게 달아드리겠습니다.

python def sieve_of_eratosthenes(n): """ 에라토스테네스의 체 알고리즘을 사용하여 2부터 n까지의 소수를 찾습니다. :param n: 범위의 최대 값 (양의 정수) :return: 2부터 n까지의 소수 리스트 """ # 0과 1은 소수가 아니므로, n+1 크기의 리스트를 False로 초기화 is_prime = [False, False] + [True] * (n - 1) # 2부터 n의 제곱근까지 반복합니다. p = 2 while p * p <= n: # 현재 숫자가 소수인 경우 if is_prime[p]: # 이 소수의 배수들을 False로 표기합니다 (소수가 아님). for i in range(p * p, n + 1, p): is_prime[i] = False p += 1 # True로 남아 있는 인덱스를 모두 소수로 반환합니다. prime_numbers = [i for i, prime in enumerate(is_prime) if prime] return prime_numbers # 사용자에게 범위 입력을 받습니다. try: n = int(input("소수를 찾을 범위의 최대 값을 입력하세요: ")) if n < 2: print("2 이상의 양의 정수를 입력해 주세요.") else: result = sieve_of_eratosthenes(n) print(f"2부터 {n}까지의 소수는 다음과 같습니다: {result}") except ValueError: print("유효한 숫자를 입력해 주세요.")

### 코드 설명

1. 함수 정의 및 입력 설명python def sieve_of_eratosthenes(n): """ 에라토스테네스의 체 알고리즘을 사용하여 2부터 n까지의 소수를 찾습니다. :param n: 범위의 최대 값 (양의 정수) :return: 2부터 n까지의 소수 리스트 """

- 함수 sieve_of_eratosthenes(n)은 사용자로부터 n 값을 받아 2부터 n까지의 소수를 반환합니다.

2. 리스트 초기화python is_prime = [False, False] + [True] * (n - 1)

- is_prime 리스트를 생성합니다. 여기서 False, False는 0과 1을 소수가 아닌 것으로 표시하고, 나머지 값들은 일단 True로 초기화합니다.

3. 에라토스테네스의 체 알고리즘python p = 2 while p * p <= n: # 현재 숫자가 소수인 경우 if is_prime[p]: # 이 소수의 배수들을 False로 표기합니다 (소수가 아님). for i in range(p * p, n + 1, p): is_prime[i] = False p += 1

- p를 2부터 시작하여 p * p가 n 이하일 때까지 반복합니다.

- is_prime[p]가 참이면, p의 배수들을 모두 False로 설정하여 소수가 아님을 표시합니다.

4. 결과 반환python prime_numbers = [i for i, prime in enumerate(is_prime) if prime] return prime_numbers

- is_prime 리스트에서 True로 남아 있는 인덱스만을 추출하여 소수 리스트를 만듭니다.

5. 사용자 입력 및 예외 처리python try: n = int(input("소수를 찾을 범위의 최대 값을 입력하세요: ")) if n < : print("2 이상의 양의 정수를 입력해 주세요.") else: result = sieve_of_eratosthenes(n) print(f"2부터 {n}까지의 소수는 다음과 같습니다: {result}") except ValueError: print("유효한 숫자를 입력해 주세요.")

- 사용자로부터 범위의 최대 값을 입력받고, 이를 기반으로 소수를 찾습니다.

- 올바른 입력 값을 확인하고 예외를 처리합니다.

이와 같이 파이썬에서 에라토스테네스의 체를 사용할 수 있습니다. 원하는 범위를 입력하여 소수를 찾으실 수 있습니다. | 네, 에라토스테네스의 체를 파이썬으로 구현하고 한국어로 주석을 달아드리겠습니다. 이 코드는 사용자로부터 범위 숫자를 입력받아 그 범위 내의 모든 소수를 찾습니다.

python def eratosthenes_sieve(n): # 2부터 n까지의 모든 숫자를 포함하는 리스트를 생성합니다. # 초기에는 모든 숫자가 소수라고 가정합니다(True로 설정). is_prime = [True] * (n + 1) # 0과 1은 소수가 아니므로 False로 설정합니다. is_prime[0] = is_prime[1] = False # 2부터 n의 제곱근까지 반복합니다. for i in range(2, int(n**0.5) + 1): # i가 소수인 경우 if is_prime[i]: # i의 배수들을 모두 소수가 아님(False)으로 표시합니다. # i*i부터 시작하는 이유는 그 이전의 배수들은 이미 이전 단계에서 처리되었기 때문입니다. for j in range(i*i, n+1, i): is_prime[j] = False # 소수인 숫자들만 리스트에 담아 반환합니다. primes = [num for num in range(2, n+1) if is_prime[num]] return primes # 사용자로부터 범위 숫자를 입력받습니다. n = int(input("2부터 몇까지의 소수를 찾을까요? ")) # 에라토스테네스의 체 함수를 호출하여 소수 리스트를 얻습니다. prime_numbers = eratosthenes_sieve(n) # 결과를 출력합니다. print(f"2부터 {n}까지의 소수:") print(prime_numbers) print(f"총 {len(prime_numbers)}개의 소수가 있습니다.")

이 코드에 대한 상세한 설명:

1. eratosthenes_sieve 함수를 정의합니다. 이 함수는 주어진 범위 내의 모든 소수를 찾습니다.

2. 함수 내에서 먼저 모든 숫자를 소수로 가정하고 True로 초기화된 리스트를 생성합니다.

3. 0과 1은 소수가 아니므로 False로 설정합니다.

4. 2부터 n의 제곱근까지 반복하면서 각 숫자의 배수들을 소수가 아님(False)으로 표시합니다. 이때 i*i부터 시작하는 이유는 그 이전의 배수들은 이미 이전 단계에서 처리되었기 때문입니다.

5. 마지막으로 True로 남아있는 숫자들(즉, 소수들)만 리스트에 담아 반환합니다.

6. 사용자로부터 범위 숫자를 입력받습니다.

7. eratosthenes_sieve 함수를 호출하여 소수 리스트를 얻습니다.

8. 결과를 출력합니다. 소수 리스트와 총 소수의 개수를 보여줍니다.

이 코드를 실행하면 사용자가 입력한 범위 내의 모든 소수를 효율적으로 찾을 수 있습니다. 에라토스테네스의 체는 대량의 소수를 빠르게 찾는 데 효과적인 알고리즘입니다. | 네, 에라토스테네스의 체를 파이썬으로 구현하고 한국어로 주석을 달아보겠습니다.

python def sieve_of_eratosthenes(n): # 0부터 n까지의 숫자 리스트 생성 numbers = list(range(n+1)) # 0과 1은 소수가 아니므로 False로 초기화 numbers[0] = numbers[1] = False # 2부터 sqrt(n)까지의 숫자를 순회 for i in range(2, int(n**0.5) + 1): if numbers[i]: # i가 소수인 경우, i의 배수들을 모두 False로 변경 for j in range(i*i, n+1, i): numbers[j] = False # 소수인 숫자들을 리스트로 반환 return [num for num in range(2, n+1) if numbers[num]] # 사용자로부터 범위 숫자 입력받기 n = int(input("숫자 범위를 입력하세요: ")) # 에라토스테네스의 체 실행 prime_numbers = sieve_of_eratosthenes(n) # 결과 출력 print(f"2부터 {n}까지의 소수:") print(prime_numbers)

주석 설명:

1. sieve_of_eratosthenes 함수를 정의하고, 매개변수 n을 받습니다.

2. 0부터 n까지의 숫자 리스트 numbers를 생성합니다.

3. 0과 1은 소수가 아니므로 numbers[0]과 numbers[1]을 False로 초기화합니다.

4. 2부터 sqrt(n)까지의 숫자를 순회합니다.

- 만약 numbers[i]가 True인 경우 (i가 소수인 경우):

- i의 배수들을 모두 False로 변경합니다. (i*i부터 시작하여 i씩 증가하면서)

5. numbers 리스트에서 True인 숫자들만 리스트로 반환합니다. (소수인 숫자들)

6. 사용자로부터 범위 숫자 n을 입력받습니다.

7. sieve_of_eratosthenes 함수를 호출하여 2부터 n까지의 소수를 구합니다.

8. 결과를 출력합니다.

이 코드는 에라토스테네스의 체 알고리즘을 사용하여 2부터 사용자가 입력한 숫자까지의 범위에서 소수를 찾아냅니다. 알고리즘의 시간 복잡도는 O(n log log n)입니다. |

실행 불가 | 실행 불가 | 2부터 몇까지의 소수를 찾을까요? 100

2부터 100까지의 소수:

[2, 3, 5, 7, 11, 13, 17, 19, 23, 29, 31, 37, 41, 43, 47, 53, 59, 61, 67, 71, 73, 79, 83, 89, 97]

총 25개의 소수가 있습니다. | 숫자 범위를 입력하세요: 100

2부터 100까지의 소수:

[2, 3, 5, 7, 11, 13, 17, 19, 23, 29, 31, 37, 41, 43, 47, 53, 59, 61, 67, 71, 73, 79, 83, 89, 97] |

Sonnet과 Opus만 실행에 성공한 모습입니다!

개인적으로 코드를 분석한 결과 저는 Sonnet에게 손을 들어주고 싶네요!

이런식으로 다양한 상황마다 댜앙한 LLM을 적용하여 비교할 수 있는 에이닷의 멀티 LLM 에이전트, 여러분도 사용해보세요!